WartoŇõńá i znaczenie automatycznej analizy danych w XXI wieku

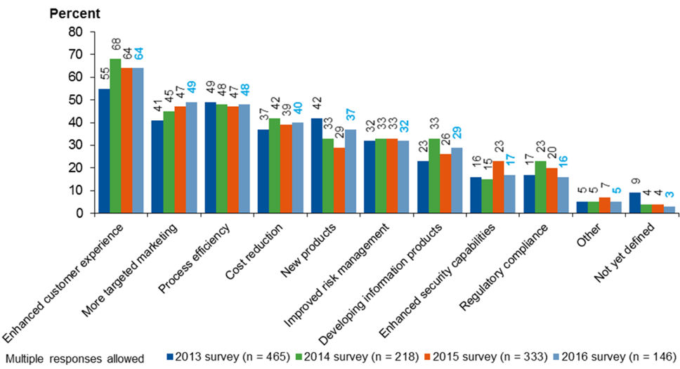

Zautomatyzowana analityka danych skŇāada obietnicńô usprawniania dziaŇāalnoŇõci firm na wielu poziomach. StńÖd inwestowanie w tzw. potocznie Big Data staŇāo sińô wyraŇļnńÖ rzeczywistoŇõcińÖ rynkowńÖ. Globalny rynek na rozwińÖzania pozwalajńÖce na gromadzenie i analizowanie wielkich zbior√≥w danych roŇõnie dynamicznie a w roku 2016 osińÖgnńÖŇā wartoŇõńá 23,8 miliarda dolar√≥w. Istnieje juŇľ wiele przykŇāad√≥w pokazujńÖcych, Ňľe inwestycje w programy Big Data przynoszńÖ zyski w postaci, czy to lepszego dotarcia do klienta, czy to optymalizacji kosztowej. Co waŇľne firmy eksperymentujńÖ takŇľe na wielu innych poziomach wykorzystania danych, jak: poprawa zarzńÖdzania ryzykiem, poprawa bezpieczeŇĄstwa, poprawa zgodnoŇõci z regulacjami prawnymi.

PobieŇľ nasz raport:¬†‚ÄěEkonomika eksploracji tekstu i danych ‚Äď analiza aktualnych trend√≥w i przyszŇāych zastosowaŇĄ‚Ä̬†

Wykres 1. Do czego wykorzystujesz analizńô wielkich zbior√≥w danych? (Gartner 2016)

Za konkretny przykŇāad lepszego marketingu moŇľe posŇāuŇľyńá amerykaŇĄski Target. Ten potentat handlu detalicznego ‚Äď poprzez analizńô nawyk√≥w zakupowych klient√≥w ‚Äď nauczyŇā sińô rozpoznawańá, kiedy kobiety regularnie korzystajńÖce ze sklep√≥w firmy, sńÖ we wczesnych miesińÖcach cińÖŇľy. Dzińôki temu trafiaŇā do nich z ofertńÖ w momencie, kiedy byŇāy najbardziej podatne na sugestie reklamowe. Przypadek ten zostaŇā dobrze opisany przez Charles‚Äôa Duhigga w Magazynie New York Times‚Äôa a nastńôpnie rozwinińôty w jego ksińÖŇľce pt. ‚ÄěSiŇāa nawyku‚ÄĚ. Praktyki tego typu wzbudziŇāy kontrowersje i pytania natury etycznej. Wydaje sińô jednak, Ňľe problem ten nie zostaŇā odpowiednio zaadresowany w debacie publicznej i dzisiaj dziaŇāania tego typu sńÖ na porzńÖdku dziennym firm ‚Äď szczeg√≥lnie tych zajmujńÖcych sińô handlem w internecie.

O wiele mniej kontrowersyjne wydaje sińô drugie najbardziej popularne zastosowanie analityki wielkich zbior√≥w danych ‚Äď niezaleŇľnie od tego, jakńÖ formńô ono przyjmuje ‚Äď a zatem nie to, kt√≥re ‚Äěszpieguje‚ÄĚ konsument√≥w uczńÖc sińô ich zachowaŇĄ po to, by lepiej wpŇāywańá na ich decyzje, a to w wyniku kt√≥rego optymalizowane sńÖ koszty prowadzenia biznesu ‚Äď takŇľe koszty Ňõrodowiskowe. Jedno z wdroŇľeŇĄ firmy Cloudera (globalnego gracza w dziedzinie Big Data, Data Miningu i zautomatyzowanej analityki) zostaŇāo zrealizowane z duŇľńÖ amerykaŇĄskńÖ firmńÖ transportowńÖ. Zainstalowano odpowiednie czujniki w cińôŇľar√≥wkach, kt√≥re zbierajńÖ dane dotyczńÖce ich ‚Äězdrowia‚ÄĚ. System zabiera dane w czasie rzeczywistym na temat ponad 150 tys. pojazd√≥w. Dzińôki automatyzowanej analizie tych informacji staŇāo sińô moŇľliwe przewidywanie awaryjnoŇõci cińôŇľar√≥wek. Innymi sŇāowy, dany pojazd moŇľna skierowańá do serwisowania zanim ulegnie awarii na trasie. OszczńôdnoŇõci sńÖ znaczńÖce ‚Äď dotyczńÖ nie tylko koszt√≥w zwińÖzanych z transportem cińôŇľar√≥wki z miejsca, w kt√≥rym ulegŇā on usterce do warsztatu naprawczego, ale takŇľe kar wynikajńÖcych z op√≥ŇļnieŇĄ w realizacji kontraktu transportowego w odpowiednim czasie. NaleŇľy takŇľe wspomnieńá o tym, iŇľ firma ta zyskuje konkretnńÖ przewagńô konkurencyjnńÖ ‚Äď moŇľna na niej polegańá w wińôkszym stopniu, poniewaŇľ w trasńô wysyŇāane sńÖ tylko te cińôŇľar√≥wki, kt√≥re jńÖ z pewnoŇõcińÖ pokonajńÖ. Zyskuje takŇľe Ňõrodowisko, jako Ňľe oszczńôdzony zostaje tzw. carbon footprint zwińÖzany z awarińÖ na trasie.

Big picture

KorzyŇõci jednostkowe z wykorzystania wielkich zbior√≥w danych i ich analizy sńÖ oczywiste a przykŇāad√≥w pojawia sińô coraz wińôcej. Jednak zautomatyzowana analityka danych skŇāada r√≥wnieŇľ obietnicńô bardziej dalekosińôŇľnńÖ. Popularne stajńÖ sińô stwierdzenia, Ňľe dane to nowa ropa ‚Äď zasadne staje sińô zatem pytanie, czy eksploracja i analityka danych zmieni nasze gospodarki r√≥wnie radykalnie co silnik spalinowy, otwierajńÖc przy tym nowe moŇľliwoŇõci rozwoju. Pytanie to jest szczeg√≥lnie waŇľne dla gospodarek europejskich, kt√≥re ‚Äď wydaje sińô ‚Äď przywykŇāy do swojej stagnacji i do kilku dobrych lat nie mogńÖ znaleŇļńá nowych stabilnych ŇõcieŇľek dalszego rozwoju.

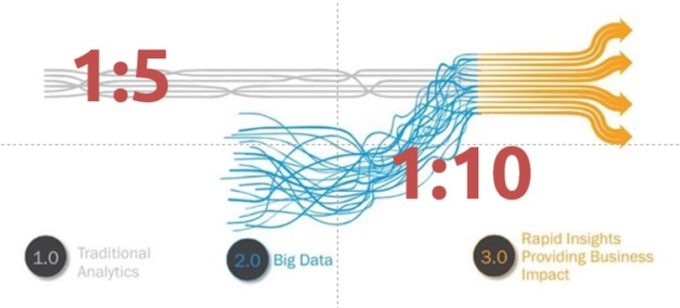

Analitycy zwińÖzani z Warszawskim Instytutem Studi√≥w Ekonomicznych (WISE) stworzyli model, na podstawie kt√≥rego wyliczyli, Ňľe wykorzystanie fenomenu Big Data przyniesie dodatkowe 1,9% PKB europejskiemu PKB juŇľ w roku 2020. Oznacza to, Ňľe odpowiednie algorytmy analityczne stosowane na poziomie mikro przyniosńÖ ponad 200 mld Euro w skali makro. Dodatkowo, ŇāńÖczńÖc analizy WISE i firmy konsultingowej IDC moŇľna wycińÖgnńÖńá wniosek, iŇľ zautomatyzowana analityka ma potencjaŇā konwersji jednego zainwestowanego w nińÖ Euro, w 10 Euro korzyŇõci makrogospodarczych. Ten potencjaŇā wpŇāywu na gospodarkńô jest ponad dwukrotnie wińôkszy, niŇľ w przypadku tradycyjnej ‚Äď liniowej ‚Äď analityki danych.

Rysunek 1. Analityka tradycyjna vs. analityka wielkich zbiorów

Jednak analizujńÖc dane z roku 2016 okazuje sińô, iŇľ wartoŇõńá caŇāego rynku Big Data dla Europy wyniosŇāa ok. 8,5 mld EUR, podczas gdy zyski makrogospodarcze zostaŇāy oszacowane na ok. 50 mld EUR. Oznacza to, Ňľe za poprzedni rok siŇāa konwersji inwestycji w rozwińÖzania zautomatyzowanej analityki byŇāa na poziomie 1:6 ‚Äď czyli ok. 20% jej caŇākowitego potencjaŇāu. MoŇľna identyfikowańá wiele przyczyn takiego stanu rzeczy. Regularne badania firmy Gartner identyfikujńÖ gŇā√≥wne bariery dla wykorzystania potencjaŇāu Big Data przez firmy, z czego rosnńÖcńÖ lukńÖ wydajńÖ sińô umiejńôtnoŇõci i kompetencje analityczne.

Wykres 2. Co stoi na przeszkodzie generowania wartoŇõci biznesowej z projekt√≥w typu Big Data? (Gartner 2016)

Jednak kluczowym wyzwaniem, kt√≥re firmy odczuwajńÖ coraz bardziej, jest kultura organizacyjna dominujńÖca w przedsińôbiorstwach usiŇāujńÖcych skorzystańá z technologii pozwalajńÖcej na zautomatyzowanńÖ analitykńô wielkich zbior√≥w danych. Jak wskazuje Forbes Insights ‚ÄěczńôŇõcińÖ problemu jest to, Ňľe modele biznesowe napńôdzane przez dane sńÖ tak odmienne od modeli biznesowych przeszŇāoŇõci, Ňľe ich wprowadzanie moŇľe spowodowańá prawdziwy wstrzńÖs w organizacji. W zasadzie z dnia na dzieŇĄ pracownicy muszńÖ uczynińá dane swoim priorytetem i muszńÖ byńá gotowi dzielińá sińô otwarcie informacjami z innymi departamentami, a takŇľe przyjńÖńá wsp√≥lnńÖ odpowiedzialnoŇõńá za zbieranie danych, ich jakoŇõńá i analizńô. Taka reforma moŇľe spowodowańá, Ňľe pracownicy bńôdńÖ ‚Äď delikatnie m√≥wińÖc ‚Äď powŇõcińÖgliwi‚ÄĚ.

AŇľ 43% firm przebadanych przez Forbesa wskazuje na znaczńÖce trudnoŇõci w rozwijaniu kultury, ‚Äěkt√≥ra docenia uŇľycie danych‚ÄĚ lub ‚Äědocenia kreatywnoŇõńá i eksperymenty zwińÖzane z analizńÖ danych‚ÄĚ. Z kolei 41% lider√≥w biznesowych twierdzi, iŇľ napotyka trudnoŇõci, kiedy pr√≥bujńÖ sprawińá, aby ich pracownicy postrzegali dane ‚Äějako wartoŇõciowy zas√≥b‚ÄĚ.

Wykres 3. Bariery kulturowe dla peŇānego wykorzystania potencjaŇāu zautomatyzowanej analityki danych (Forbes Insight 2016)

Wydaje sińô, zatem, iŇľ doprowadzenie do sytuacji, w kt√≥rej firmy zacznńÖ odczuwańá realne korzyŇõci z implementacji zautomatyzowanej analityki wymaga zmian niezwińÖzanych bezpoŇõrednio z technologińÖ, a raczej z postawami i umiejńôtnoŇõciami analitycznymi pracownik√≥w. Innymi sŇāowy, wprowadzanie technologii musi iŇõńá w parze z implementowaniem program√≥w rozwoju kompetencyjnego nie tylko dla wńÖskich kadr IT, ale we wszystkich kluczowych departamentach firmy. Tylko w√≥wczas, zas√≥b w postaci danych bńôdzie m√≥gŇā byńá zamieniany na aktywa biznesowe w spos√≥b cińÖgŇāy; co, z kolei zagwarantuje optymalizacjńô zwrot√≥w pozyskiwanych z inwestycji w projekty typu Big Data. Bez takich zmian ‚Äď a sńÖ to zmiany gŇāńôbokie ‚Äď automatyka analityczna moŇľe sińô okazańá nie tak przeŇāomowa dla gospodarek, jak jest reklamowana.

PrzygotowujńÖc ten wpis korzystaŇāem z nastńôpujńÖcych publikacji:

- Buchholtz, Sonia, Maciej Bukowski, Aleksander Ňöniegocki. 2014. Big and open data in Europe. A growth engine or a missed opportunity?, Warszawa: demosEUROPA, Warsaw Institute for Economic Studies.

- Forbes Insights. 2015. Betting on Big Data. How the right culture, strategy and investments can help you leapfrog the competition. Washington.

- Ransbotham, Sam, David Kiron, Pamela Kirk Prentice. 2015. The talent dividend. Analytics talent is driving competitive advantage at data-oriented companies. MIT Sloan Management Review.

- Vesset, Dan et al. 2015. IDC FutureScape: Worldwide Big Data and Analytics 2016 Predictions, Framingham: IDC Analyze the Future.

Raport „Ekonomika eksploracji tekstu i danych ‚Äď analiza aktualnych trend√≥w i przyszŇāych zastosowaŇĄ‚ÄĚ powstaŇā w ramach projektu FutureTDM, kt√≥rego Centrum Cyfrowe jest partnerem.