Trump na wspГіЕӮczesnej agorze. O moderowaniu treЕӣci na Twitterze i Facebooku

Ze StanГіw Zjednoczonych docierajД… do nas informacje i zdjДҷcia z protestГіw #BlackLivesMatter – zamiatany pod dywan problem systemowego rasizmu wyprowadziЕӮ ludzi na ulice. Gdy jednak przyjrzymy siДҷ temu, co dzieje siДҷ w amerykaЕ„skich mediach spoЕӮecznoЕӣciowych, zauwaЕјymy, Ејe one teЕј wirtualnie вҖһstanДҷЕӮy w ogniuвҖқ – opinia publiczna, pracownicy – w niektГіrych przypadkach same platformy internetowe – przestaЕӮa udawaДҮ, Ејe obecne zasady dotyczД…ce moderacji treЕӣci sД… wystarczajД…ce. A przyczyniЕӮ siДҷ do tego nikt inny jak prezydent Trump.

Co mogД… nowi doradcy Facebooka

Na poczД…tku maja mocno komentowano ogЕӮoszenie skЕӮadu Facebook Oversight Board – niezaleЕјnego ciaЕӮa, ktГіre bДҷdzie doradzaЕӮo firmie w sprawie moderowania i usuwania treЕӣci. Facebook projektowaЕӮ radДҷ przez kilka lat, a temat budziЕӮ wiele kontrowersji. Ostatecznie powstaЕӮo ciaЕӮo, w ktГіrego skЕӮad weszli takЕјe krytycy dziaЕӮaЕ„ firmy (np. Helle Thorning-Schmidt, byЕӮa premierka Danii i Michael W. McConnell – profesof prawa z Uniwerytettu Columbia). NajwiДҷkszym wyzwaniem dla rady jest brak wiД…ЕјД…cej mocy podejmowanych przez niД… decyzji – firma moЕјe siДҷ do nich zastosowaДҮ albo zupeЕӮnie je zignorowaДҮ. Sami pisaliЕӣmy o tym, Ејe realnД… pozycjДҷ rady okreЕӣli to, w jaki sposГіb Facebook zareaguje na jej rekomendacje.В Nikt jednak nie przewidziaЕӮ, jak szybko rada stanie przed pierwszym testem skutecznoЕӣci.

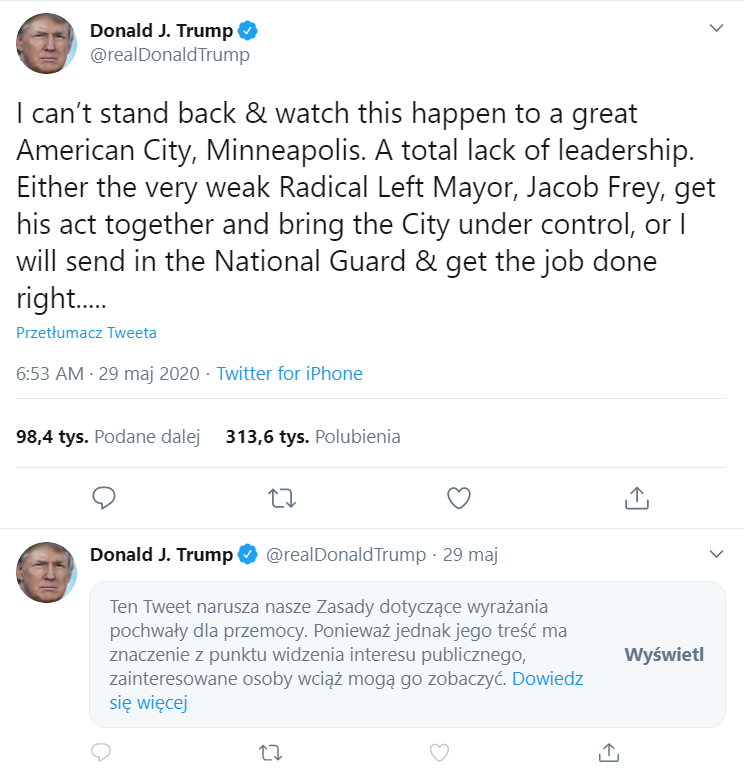

W nastДҷpstwie kontrowersji wokГіЕӮ postГіw prezydenta Trumpa na temat ogГіlnokrajowych protestГіw (ktГіre Twitter i Snapchat uznaЕӮy za promujД…ce przemoc, a Facebook za zgodne ze standardami spoЕӮecznoЕӣci), niektГіrzy postulowali (gЕӮГіwnie poprzez tweety), by nowa rada zainterweniowaЕӮa i oceniЕӮa sytuacjДҷ. W odpowiedzi w ЕӣrodДҷ opublikowano nieco przepraszajД…cД… notatkДҷ wyjaЕӣniajД…cД…, dlaczego rada nie moЕјe tego zrobiДҮ – z wielu powodГіw po prostu nie jest gotowa, poza tym jej rolД… nie jest ocenianie zachowaЕ„ firmy w kontekЕӣcie bieЕјД…cych wydarzeЕ„ politycznych.

RzeczywiЕӣcie Facebook informowaЕӮ, Ејe na poczД…tku rada bДҷdzie decydowaЕӮa tylko o tym, czy konkretne posty zostaЕӮy sЕӮusznie usuniДҷte z serwisu czy popeЕӮniono bЕӮД…d i naleЕјy je przywrГіciДҮ. Docelowo miaЕӮaby jednak kreowaДҮ standardy dotyczД…ce moderowania treЕӣci. Nie jest jednak jasne, jak szybko rada zacznie rzeczywiЕӣcie dziaЕӮaДҮ – kluczowe wydaje siДҷ pytanie, czy zdД…Ејy przed wyborami prezydenckimi w Stanach tej jesieni.

Wszystko sprowadza siДҷ do odpowiedzi na pytanie, z ktГіrym Facebook sЕӮyszyВ coraz czДҷЕӣciej – rГіwnieЕј ze strony wЕӮasnych pracownikГіw, ktГіrzy w akcie protestu za brak reakcji na ostatnie posty Trumpa organizujД… wirtualne strajki. Czy platforma bДҷdzie zwierciadЕӮem dla wszystkich trendГіw i nastrojГіw spoЕӮecznych, czy jednak powie вҖһnieвҖқ tym nieakceptowanym spoЕӮecznie, jak rasizm? Zuckerberg od dawna powtarza, Ејe chce uniknД…ДҮ вҖһfaЕӮszowaniaвҖқ usЕӮug firmy na rzecz konkretnego punktu widzenia – zamiast tego, gdy tylko jest to moЕјliwe, ma nadziejДҷ walczyДҮ z niepoЕјД…danymi wypowiedziami wiДҷkszД… iloЕӣciД… wypowiedzi o innym charakterze.

Twitter vs. @realDonaldTrump

IstniejД… rГіЕјne metody przeciwdziaЕӮania dezinformacji – fact checking (weryfikacja informacji) jak na razie jest najbardziej skutecznД…. Po latach krytyki Twitter po raz pierwszy dodaЕӮ informacje weryfikujД…ce do tweetГіw prezydenta Trumpa. Tweety dotyczyЕӮy gЕӮosowania korespondencyjnego, a platforma dodaЕӮa do nich zakЕӮadkДҷ вҖңpoznaj fakty na temat gЕӮosowania wysЕӮanego pocztД…вҖң. Rzeczniczka prasowa firmy podkreЕӣliЕӮa, Ејe tweet prezydenta zawieraЕӮ informacje, ktГіre mogД… wprowadzaДҮ w bЕӮД…d, dlatego zdecydowano siДҷ na odesЕӮanie uЕјytkownikГіw po dodatkowe informacje w tym temacie.

….living in the state, no matter who they are or how they got there, will get one. That will be followed up with professionals telling all of these people, many of whom have never even thought of voting before, how, and for whom, to vote. This will be a Rigged Election. No way!

вҖ” Donald J. Trump (@realDonaldTrump) May 26, 2020

Twitter zdecydowaЕӮ siДҷ na rozwiД…zanie, ktГіre z jednej strony podkreЕӣla odpowiedzialnoЕӣДҮ platform za treЕӣci na nich publikowane, a z drugiej nie prowadzi do sytuacji, gdy to podmiot prywatny musi decydowaДҮ, co jest prawdД…, a co nie – ale decyzjДҷ pozostawia uЕјytkownikom. DecyzjДҷ Twittera moЕјna byЕӮo przewidzieДҮ, ЕӣledzД…c na jego poprzednie dziaЕӮania Twittera mГіgЕӮ byДҮ do – w styczniu firma zaczД…ЕӮa zezwalaДҮ uЕјytkownikom na oznaczanie tweetГіw zawierajД…cych mylД…ce informacje na temat sposobu gЕӮosowania. W przypadku prezydenta Trumpa zastosowaЕӮa tДҷ politykДҷ, uczciwie i ze wzglДҷdnД… precyzjД…. ChociaЕј niektГіrzy krytykowali to, Ејe etykieta nie krzyczy вҖһprezydent kЕӮamie na ten tematвҖқ.

Na reakcjДҷ ze strony BiaЕӮego Domu nie trzeba byЕӮo dЕӮugo czekaДҮ – Trump wydaЕӮ dekret prezydencki (executive order) nakazujД…c sekretarzowi handlu Wilburowi Rossowi zwrГіcenie siДҷ do Federalnej Komisji ds. Komunikacji o nowe przepisy w celu ustalenia, czy platforme spoЕӮecznoЕӣciowa dziaЕӮajД… вҖһw dobrej wierzeвҖқ w celu moderowania treЕӣci.

WspГіЕӮczesna agora - dobro wspГіlne w prywatnych rДҷkach

Co ЕӮД…czy te oba przypadki? Dobitnie pokazujД… one, Ејe media spoЕӮecznoЕӣciowe sД… wspГіЕӮczesnД… agorД… – agorД… w rДҷkach prywatnych, ale sЕӮuЕјД…cД… do publicznej komunikacji, rГіwnieЕј na linii wЕӮadza-obywatele. DoЕӣДҮ uprzywilejowane wydaje siДҷ podejЕӣcie вҖһjak ci siДҷ nie podoba na Facebooku, to nie korzystajвҖқ – wiele osГіb nie ma kompetencji ani moЕјliwoЕӣci, by korzystaДҮ z internetu poza platformami internetowymi, skutecznie siДҷ komunikowaДҮ i pozyskiwaДҮ informacje. Dlatego teЕј w duchu dbania o spoЕӮeczny wymiar technologii potrzebna jest dyskusja o tym, jakiej komunikacji potrzebujemy i chcemy na platformach internetowych.В

NajwaЕјniejsze dzisiaj pytanie brzmi –В w jaki sposГіb platformy internetowe powinny moderowaДҮ treЕӣci uЕјytkownikГіw? A odpowiadajД…c na nie, nie unikniemy kwestii regulacji i wyzwaЕ„, jakie z sobД… niesie. Regulacja musi pogodziДҮ interesy, ktГіre wydajД… siДҷ wzajemnie wykluczaДҮ – po pierwsze uЕјytkownicy powinni mieДҮ prawo wyraЕјania swoich opinii i poglД…dГіw (czДҷsto kontrowersyjnych, ale legalnych). Po drugie musi ona teЕј daДҮ platformom internetowym skuteczne narzДҷdzia do reagowania w sytuacji ЕӮamania prawa (np. treЕӣci nawoЕӮujД…cych do nienawiЕӣci). NiewД…tpliwie moderacja treЕӣci, mechanizmy odwoЕӮawcze i zasady wyЕӮД…czenia odpowiedzialnoЕӣci platform internetowych za treЕӣci zamieszczane przez uЕјytkownikГіw bДҷdД… przedmiotem debaty wokГіЕӮ nowego unijnego projektu kodeksu usЕӮug cyfrowych (Digital Services Act) – wstДҷpne postulaty Centrum Cyfrowego w tym temacie sД… do znalezienia na blogu.

Poza tym regulacja to jednak nie wszystko (szczegГіlnie Ејe czДҷsto, na przykЕӮad na poziomie unijnym, jej wprowadzenie zajmuje lata). Platformy internetowe, dziaЕӮajД…ce niemal jak usЕӮugi publiczne, muszД… takЕјe wypracowywaДҮ skuteczne i dziaЕӮajД…ce mechanizmy samoregulacji (tutaj liczba pomysЕӮГіw na formДҷ jest nieskoЕ„czona – flagowanie treЕӣci, ciaЕӮa nadzorujД…ce, kodeksy dobrych praktyk). Tylko Ејe te mechanizmy powinny uwzglДҷdniaДҮ moЕјliwoЕӣДҮ kontroli spoЕӮecznej, a po drugie nie mogД… zastД…piДҮ regulacji –В samoregulacja i regulacja platform to powiД…zane dziaЕӮania.

Natalia MileszykВ @nmileszyk вҖ“ prawniczka zajmujД…ca siДҷ prawami cyfrowymi, reformД… prawa autorskiego i politykami otwartoЕӣciowymi. CzЕӮonkini Stowarzyszenia Communia na rzecz domeny publicznej, gdzie koordynuje zespГіЕӮ rzeczniczy oraz ekspertka prawnego Creative Commons Polska.

BIULETYN SPOЕҒTECH

Tekst ukazaЕӮ siДҷ w Biuletynie SpoЕӮTech. JeЕӣli chcesz wiedzieДҮ, jak technologia oddziaЕӮuje na ludzi i spoЕӮeczeЕ„stwo вҖ“ zapisz siДҷ do Biuletynu!!В Co dwa tygodnie dzielimy siДҷ z Wami przemyЕӣleniami zwiД…zanymi ze spoЕӮecznym wymiarem technologii.